Адаптивное поведение агента: акцептор результатов действий и эфферентный синтез

Аннотация

Дата поступления статьи: 05.12.2013Рассмотрены особенности механизмов предсказания и оценки результатов действий интеллектуального агента. Построение процедур планирования и и коррекции тактики и стратегии поведения основано на кибернетической схеме функциональных систем. Данная схема является концепцией архитектуры интеллектуального агента.

Ключевые слова: Интеллектуальный агент, адаптивное поведение, модель достижения цели, механизм эфферентного синтеза

05.13.18 - Математическое моделирование, численные методы и комплексы программ

Введение

Одним из направлений исследований в области многоагентных систем является исследование архитектур агентов, как программных систем, которые удовлетворяют определенным свойствам [1]. В зависимости от наличия этих свойств различают разные типы агентов. В частности, используют «слабое» и «сильное» определение интеллектуального агента. В первом случае интеллектуальный агент, как программно-аппаратная система, должен обладать следующими свойствами: автономностью, общественным поведением, реактивностью, про-активностью. Сильное определение дополнительно к этим свойствам предполагает наличие таких «ментальных свойств», как знания, убеждения, желания, намерения, цели, обязательства и др. На сегодня формализация ментальных понятий основана на использовании различных логик исследований в рамках искусственного интеллекта. В частности, в основу архитектуры ART положена теория адаптивного резонанса Гроссберга [2]. Архитектура CERA-CRANIUM использует теорию сознания [3]. Архитектура Chrest является примером исследовательской архитектуры для выяснения роли перцептивных механизмов в общем мыслительном процессе [4]. Вместе с тем, архитектура агента должна демонстрировать реализацию разных свойств в их определенной взаимосвязи. Одной из концепций, позволяющих перейти к построению подобной архитектуры, является концепция функциональных систем, разработанная А.П. Анохиным. Согласно этой концепции поведенческий акт состоит из следующих стадий: афферентного синтеза, принятия решений, акцептора результата действий, эфферентного синтеза, формирования действия и оценки достигнутого результата [5]. На завершающем этапе поведенческого акта важнейшая роль принадлежит акцептору результата действия (АРД), как механизму предвидения будущих результатов действий, выбору действий, оценки полученных результатов и изменения тактики и стратегии поведения в зависимости от оценки (рис.1).

Рис.1. Особенности поведенческого акта на стадиях эфферентного синтеза и оценки результатов

В соответствии с данной схемой функционирование АРД начинается с построения модели цели, позволяющей уточнить оптимальный план конкретными решениями и оценками, как результатов, так и рисков, связанных с реализацией решений в зависимости от имеющихся ресурсов. На основе анализа ограничений на ресурсы и рисков определяется оптимальная стратегия достижения цели, которой стремиться придерживаться агент. После первого действия (решения) сравнивается полученный результат с ожидаемым результатом. В случае их совпадения выбирается следующее действие согласно оптимальной стратегии. В случае несовпадения осуществляется коррекция модели достижения цели с изменением оптимальной стратегии. Подобный характер поведения агента в динамической среде отмечается в [6].

Целью настоящей работы является формализация механизмов эфферентного синтеза и АРД.

1. Построение модели достижения цели акцептором результата действий

Если на стадии афферентного синтеза решается задача формирования всех возможных планов действий агента, то на стадии принятия решений решается задача выбора одного плана, оптимального с точки зрения определенных критериев. В обоих случаях речь идет об обобщенных, не конкретизированных, планах. Перед переходом к конкретным действиям АРД необходимо конкретизировать выбранный план действий с учетом собственного состояния, изменения состояния среды после принятия решений, неопределенностей и рисков реализации действий. Такой конкретизированный план назовем моделью достижения цели. Как и раннее, предполагаем, что поведенческий акт агента определен не на одном действии, а на совокупности действий. Иными словами поведенческий акт представляет собой процесс, связанный с решением многошаговой задачи. Однако суть модели достижения цели проще пояснить на примере одношаговой задачи.

Часто кошки любят сидеть на подоконнике, наблюдая ситуацию за окном. В данном случае доминирующей потребностью может быть любопытство и желание оказаться за пределами квартиры. На стадии афферентного синтеза может быть построено множество планов, связанных с разными окнами квартиры. Предположим, что на этапе принятия решений выбран план, предполагающий расположение кошки на определенном подоконнике. Если кошка находится около нужного окна, то она решет одношаговую задачу (выбранный план) с одним действием – прыжок. Казалось бы реализации выбранного плана действий достаточно для реализации цели. Однако опыт и инстинкт подсказывают, что на подоконнике могут оказаться посторонние предметы, разлита вода и т.п. Поэтому АРД конкретизирует выбранный план, например, за счет использования правил:

Если на любимом месте – кастрюля, то действие – прыжок в правую сторону;

Если любимое место занято, то отказ от цели;

Если любимое место вне видимости, но на этом месте может быть вода, то действие – прыжок и отход в сторону.

Такая конкретизация плана связана не с планированием, а с моделированием возможных ситуаций и реализацией плана действий на основе их анализа.

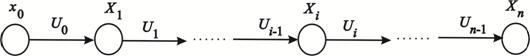

Пусть X=<x0, X1, …, Xi, …, Xn> - последовательный дискретный процесс решения задачи, причем Xi={Xi,1, …, Xi,k}, ![]() - возможные результаты реализации i-го этапа при использовании действий Ui-1, x0 – начальное состояние задачи (рис.2).

- возможные результаты реализации i-го этапа при использовании действий Ui-1, x0 – начальное состояние задачи (рис.2).

Рис.2. Многошаговый процесс решения задачи

Модель достижения цели Xn представляет собой множество путей из вершины x0 в вершины Xn. При построении модели необходимо учитывать следующие обстоятельства:

- зависимость результатов i-го шага от результатов (i-1)-шага;

- наблюдения и измерения агента приблизительны и субъективны;

- результаты действий неоднозначны в силу отсутствия полной картины внешней среды.

Данные обстоятельства позволяют использовать, при построении модели достижения цели, мягкие вычисления на основе нечеткой логики. При этом, предполагается поведение агента при следующих допущениях:

- известны нечеткие матрицы переходов от одного этапа к другому этапу при использовании одного из действий M(Xi-1, Xi)/Ui-1, ![]() ;

;

- агенту известны нечеткие предпочтения выбора действий в каждом из состояний в виде вектора µ(x0, U0) и матриц M(Xi, Ui);

- известен прогноз получения возможных результатов X1 при применении различных действий U0 в начальном состоянии x0;

- на финальном множестве Xn задана нечеткая цель µ(Xn).

Построение модели осуществляется на основе решения следующей системы уравнений [7]:

. (1)

. (1)

Для определения соответствия результата и действия будем использовать следующее условие µ(Ui)≤µ(Xi)/Ui-1. Это условие позволяет сопоставить конкретному результату Xi, характеризуемому нечеткой оценкой µ(Xi)/Ui-1, действие Ui, предпочтение которого µ(Ui) близко по значению этой оценке.

Результаты построений наглядно представимы в виде нечеткого ориентированного графа G=(X, M), где M={µG(Xi-1, Xi)} – множество принадлежностей элементов Xi-1* Xi. Пример моделирования изображен на рисунке 3.

Рис.3. Пример модели достижения цели

Здесь, дуги маркируются как действиями, так и нечеткими оценками их предпочтения.

2. Механизм эфферентного синтеза

Основным назначением механизма эфферентного синтеза является выделение оптимальной стратегии поведения, исходя из анализа текущей обстановки и имеющейся модели достижения цели. Адекватным подходом для решения такой задачи является метод нечеткого динамического программирования Беллмана-Заде [8]. Данный метод основан на нечетких оценках цели и ограничений. Рассмотрим финальное множество Xn и в зависимости от его оценок µ(Xn) выделим классы возможных стратегий агента. В первую очередь, нас будут интересовать стратегии агента, позволяющие достичь конечного результата, который характеризуется оценкой равной max{µ(Xn)}. На (n-1)-м шаге выделим результаты, переход из которых в целевые состояния n-го шага характеризуется использованием действий с оценкой равной

![]() , (2)

, (2)

где ![]() – результаты n-го шага.

– результаты n-го шага.

Далее (2) применяется для каждого этапа решения задачи, вплоть до состояния x0. В результате получим путь на графе, позволяющий достичь конечного результата с оценкой равной max{µ(Xn)}. Аналогично можно выделить стратегии агента и для других результатов ![]() . В общем случае будем иметь q взвешенных путей от x0 до

. В общем случае будем иметь q взвешенных путей от x0 до ![]() :

: ![]() , где rw, w=

, где rw, w=![]() – число результатов на w-м этапе решения задачи.

– число результатов на w-м этапе решения задачи.

Задание на множестве Xn нечеткой цели характеризует различную для агента ценность конечных результатов. Пусть размерность Xn равна h. Тогда ![]() , а

, а ![]() есть функция принадлежности результата

есть функция принадлежности результата ![]() нечеткой цели. В этом случае каждая стратегия из класса k характеризуется оценкой вида [7]:

нечеткой цели. В этом случае каждая стратегия из класса k характеризуется оценкой вида [7]:

![]() . (3)

. (3)

Стратегия с оценкой равной ![]() определяет такое поведение агента, которое позволяет достичь предпочитаемой цели и удовлетворяет ограничениям, связанных с выбором действий.

определяет такое поведение агента, которое позволяет достичь предпочитаемой цели и удовлетворяет ограничениям, связанных с выбором действий.

3. Уточнение модели достижения цели

Стратегия, характеризуемая оценкой ![]() может соответствовать не максимальному конечному результату, а ее выбор определен имеющимися, на момент анализа, ограничениями. В ходе решения задачи ограничения могут измениться как лучшую, так и в худшую, стороны. Реакцией агента на подобные изменения может быть переосмысление предпочтений и выбор действий, которые не соответствуют зафиксированной оптимальной стратегии. В этом случае требуется уточнение модели достижения цели. Уточнение модели возможно на основе следующих способов:

может соответствовать не максимальному конечному результату, а ее выбор определен имеющимися, на момент анализа, ограничениями. В ходе решения задачи ограничения могут измениться как лучшую, так и в худшую, стороны. Реакцией агента на подобные изменения может быть переосмысление предпочтений и выбор действий, которые не соответствуют зафиксированной оптимальной стратегии. В этом случае требуется уточнение модели достижения цели. Уточнение модели возможно на основе следующих способов:

– изменения предпочтений агента;

– изменения исходных матриц переходов и выходов;

– использования механизмом эфферентного синтеза смешанных стратегий.

Первые два способа предполагают построение новых моделей достижения цели, что для ряда задач может быть неэффективно с точки зрения выделенных ресурсов, либо требуемой скорости реакции на текущую ситуацию. В этой связи рассмотрим реализацию последнего способа, который предполагает адаптивное поведение агента, ориентированного только на конечный результат с максимальной функцией принадлежности.

Под смешанной стратегией понимается стратегия, образованная частями стратегий из классов k. Однако, не для любого этапа решения задачи возможен синтез такой стратегии. Для определения такой возможности в [9] введен коэффициент свободы выбора (КСВ), позволяющий качественно оценить уровень возможности агента в выборе альтернативных действий. Под КСВ понимается отношение числа допустимых стратегий из класса ![]() , характеризуемых оценкой

, характеризуемых оценкой ![]() к общему числу стратегий из этого же класса. Уточнение модели достижения цели, на основе КСВ, заключается в следующих шагах:

к общему числу стратегий из этого же класса. Уточнение модели достижения цели, на основе КСВ, заключается в следующих шагах:

– выбором тех действий, которые являются составными частями допустимых стратегий с большими значениями КСВ (больше 0,5) или, по крайней мере, значениями КСВ неравными или близкими нулю;

– в случае отсутствия предыдущей возможности использовать смешанную стратегию, которая имеет меньшие возможности в реализации оптимальной стратегии, но остается допустимой по отношению к достижению ожидаемого результата.

Общий алгоритм построения и использования модели достижения цели АРД состоит в следующем:

1. Определение исходных параметров предварительной модели достижения цели:

- число этапов решение задачи n;

- результаты каждого этапа;

- действия, которые можно реализовать на каждом этапе;

- матрицы переходов M(Xi-1, Xi)/Ui-1, ![]() .

.

2. Задание исходных данных:

- функция принадлежности цели решения задачи ![]() ;

;

- нечеткие предпочтения использования действий ![]() ;

;

- при необходимости функции выходов модели, которые позволят фиксировать возможные затраты для достижения результата на определенном этапе решения задачи при выборе конкретного действия ![]() .

.

3. Построение модели:

- для каждого i-го этапа решаются уравнения (1) для действий ![]() с вычислением оценок предпочтений выбора результатов и действий следующего (i+1)-го этапа;

с вычислением оценок предпочтений выбора результатов и действий следующего (i+1)-го этапа;

- определяются соответствия результата и действия на основе условия µ(Ui)≤ µ(Xi)/Ui-1.

- на основе предпочтений соответствий «действие» - «результат действия» формируется нечеткий ориентированный граф, дуги которого маркируются конкретным действием с нечеткими оценками переходов от вершины к вершине, а также оценками затрат (при необходимости) на реализацию соответствующих действий (рис.3);

4. Определение возможных стратегий поведения агента ![]() и классов стратегий, упорядоченных по убыванию относительно функций принадлежности

и классов стратегий, упорядоченных по убыванию относительно функций принадлежности ![]() .

.

5. Выделение оптимальной стратегии поведения, исходя из критерия ![]() ;

;

6. Переход к смешанной стратегии, в случае отклонения от оптимальной стратегии.

Заключение

Рассмотренный подход позволяет реализовать процедуры самоорганизации поведения на стадиях эфферентного синтеза и оценки результатов действий интеллектуального агента. Особенность самоорганизации состоит в возможности коррекции первоначально построенного плана действий, в зависимости от достигнутых результатов действий.

За рамками данной работы остались вопросы, связанные с реализацией таких механизмов АРД как передача полномочий по реализации отдельных этапов решения задачи другим агентам [10, 11].

Работа выполнена при финансовой поддержке РФФИ (проект №12-01-00766-a)

Литература:

1. Городецкий В.И., Грушинский М.С., Хабалов А.В. Многоагентные системы (обзор)//Новости искусственного интеллекта, №2, 1998.- С.64-117.

2. Grossberg S. Competitive Learning: From Interactive Activation to Adaptive Resonance, Cognitive Science 11, 1987, pp. 29-63

3. Arrabales R, Ledezma A. and Sanchis A. CERA-CRANIUM: A Test Bed for Machine Consciousness Research/International Workshop on Machine Consciousness 2009. Hong Kong. June 2009, pp.1-20.

4. Gobet F., & Lane P. The CHREST architecture of cognition: The role of perception in general intelligence. In E. Baum, M. Hutter, &E. Kitzelmann (Eds.), Third conference on artificial general intelligence (AGI’10). Amsterdam, The Netherlands: Atlantis Press, 2010, pp.7-12

5. Анохин П. К. Теория функциональной системы//Успехи физиол. наук". Т.1, № 1, 1970.-С.19-54.

6. Funke, J. Complex problem solving: A case for complex cognition?//Cognitive Processing, 11(2), 2010, pp.133–142.

7. Астанин С.В. Автоматные модели поведения стратегического управления// Изв.ТРТУ. Интеллектуальные САПР. – Таганрог: Изд. ТРТУ, 1997.-С.176-178

8. Беллман Р, Заде Л. Принятие решений в расплывчатых условиях В сб.: Вопросы анализа и процедуры принятия решений.-М: Мир, 1976.-С.172-215.

9. Астанин С.В. Сопровождение процесса обучения на основе нечеткого моделирования//Открытое образование, №5, 2000.-С.37-44

10. Астанин С.В., Драгныш Н.В., Жуковская Н.К. Вложенные метаграфы как модели сложных объектов [Электронный ресурс]// «Инженерный вестник Дона», 2012, №4. – Режим доступа: http://www.ivdon.ru/magazine/archive/n4p2y2012/1434

11. Жуковская Н.К. Согласование интересов в иерархических системах [Электронный ресурс]// «Инженерный вестник Дона», 2011, №4. – Режим доступа: http://www.ivdon.ru/magazine/archive/n4y2011/584